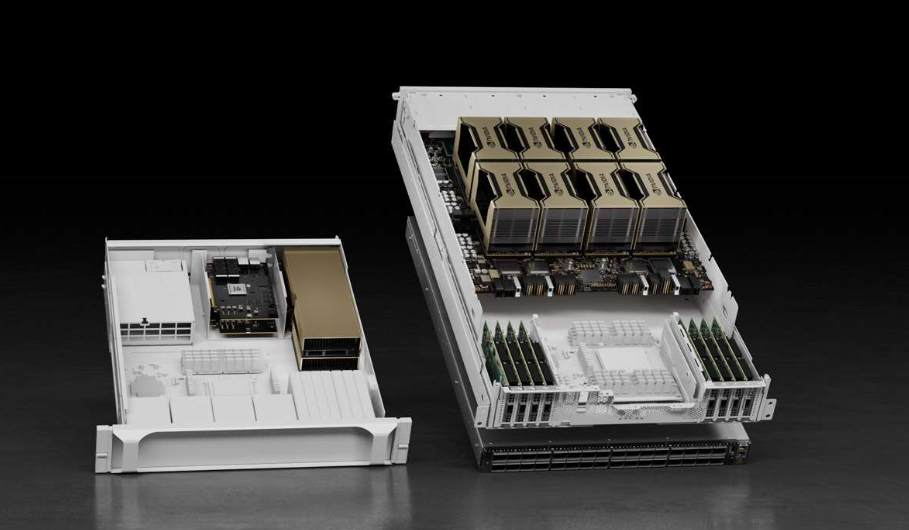

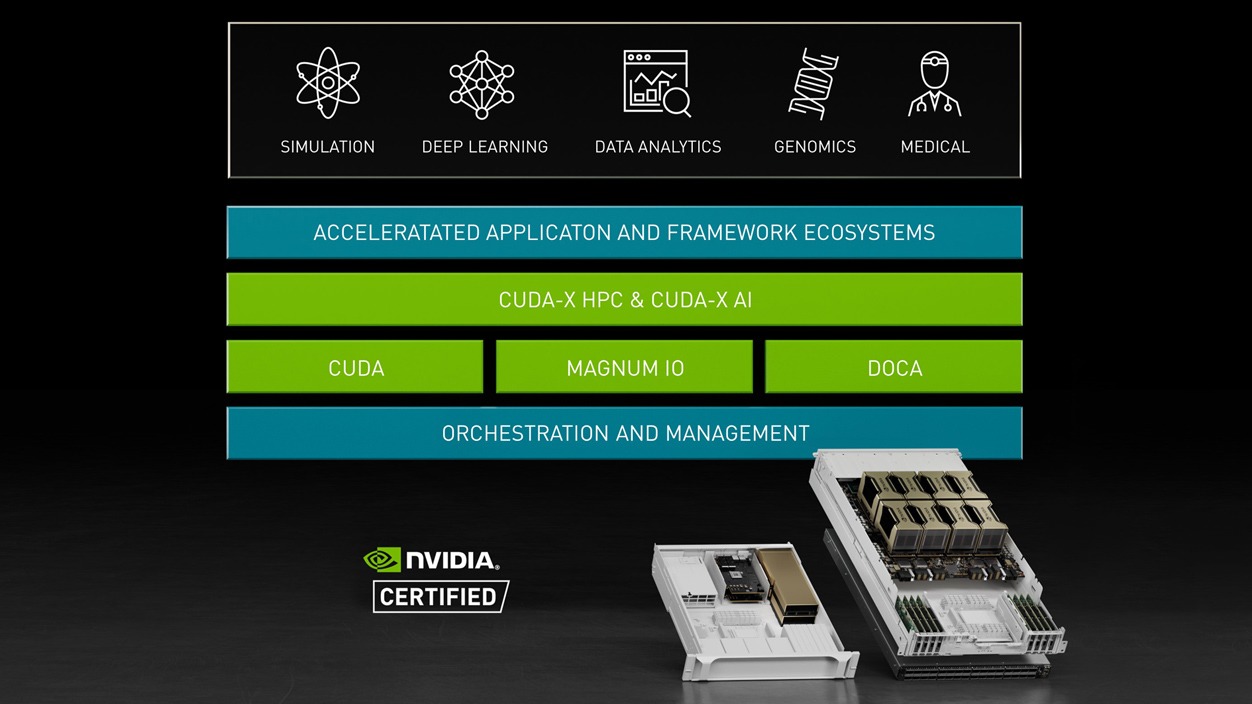

NVIDIA HGX 將 NVIDIA A100 Tensor Core GPU 與高速互連技術(shù)相結(jié)合,打造功能強大的服務(wù)器。HGX 擁有 16 個 A100 GPU,具有高達 1.3 TB 的 GPU 顯存和超過 2 TB/秒的顯存帶寬,可實現(xiàn)非凡加速。

與前幾代產(chǎn)品相比,HGX 借助 Tensor Float 32 (TF32) 開箱即可為 AI 提供高達 20 倍的加速,同時借助 FP64 實現(xiàn) 2.5 倍的 HPC 加速。NVIDIA HGX 提供了令人驚嘆的 10 petaFLOPS,為 AI 和 HPC 領(lǐng)域打造出全球性能強勁的加速擴展服務(wù)器平臺。

HGX 經(jīng)過全面測試且易于部署,可集成至合作伙伴服務(wù)器中,以提供有保證的性能。HGX 平臺提供 4-GPU 和 8-GPU HGX 主板并采用 SXM GPU,也可采用 PCIe GPU 的形式以提供模塊化部署選項,為主流服務(wù)器帶來卓越計算性能。