最新發布的NVIDIA Jetson AGX Orin提升邊緣AI標桿,使我們在最新一輪行業推理基準測試中的領先優勢更加明顯。

April 6, 2022 by 英偉達中國

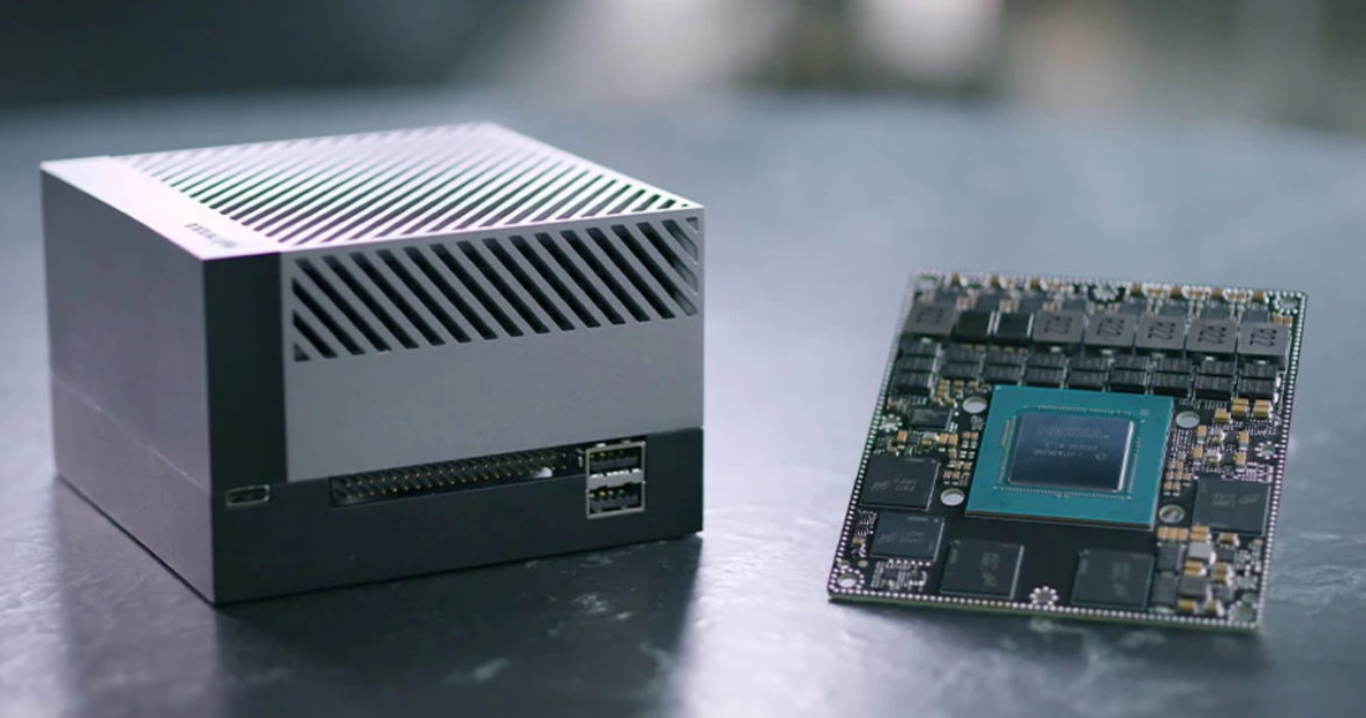

在首次參加行業MLPerf基準測試時,基于NVIDIA Ampere架構的低功耗系統級芯片NVIDIA Orin就創造了新的AI推理性能紀錄,并在邊緣提升每個加速器的性能。

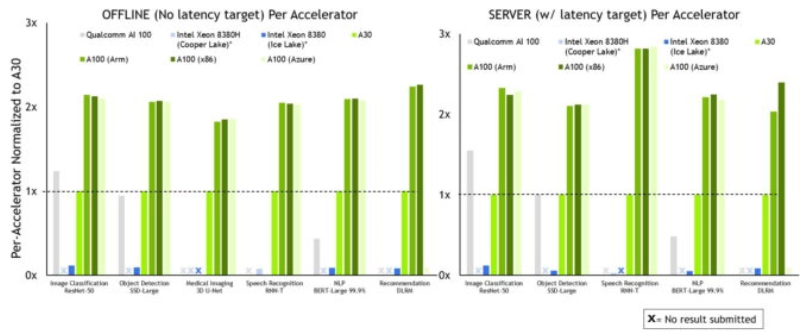

在此次第五輪生產級AI行業基準測試中,NVIDIA及其合作伙伴繼續在所有機器學習的工作負載和場景中展現出了高性能和廣泛的生態系統。

在邊緣AI領域,NVIDIA Orin預生產版本在六項性能測試中的五項處于領先地位,其運行速度比上一代Jetson AGX Xavier快了5倍,能效平均提高了2倍。

NVIDIA Orin現已加入到用于機器人和自動化系統的NVIDIA Jetson AGX Orin開發者套件。包括亞馬遜網絡服務、約翰迪爾、小松、美敦力和微軟Azure在內的6000多家客戶使用NVIDIA Jetson平臺進行AI推理或其他任務。

這款系統級芯片也是NVIDIA Hyperion自動駕駛汽車平臺的關鍵組成部分。中國最大的電動汽車制造商比亞迪近期宣布,他們將在其新一代自動駕駛電動汽車中使用內置Orin的DRIVE Hyperion架構。

Orin同樣也是NVIDIA Clara Holoscan醫療設備平臺的關鍵組成部分,且該平臺可供系統制造商和研究人員用來開發新一代AI儀器。

小模塊合體成為大堆棧

包括Jetson AGX Orin在內的NVIDIA GPU是唯一能夠運行所有六項MLPerf基準測試的邊緣加速器。

憑借JetPack SDK,Orin可以運行整個NVIDIA AI平臺,這個軟件堆棧已經在數據中心和云端得到了驗證,并且獲得了NVIDIA Jetson平臺100萬名開發者的支持。

在最新一輪MLPerf推理測試中,NVIDIA及合作伙伴繼續在所有測試和場景中展現出領先的性能。

MLPerf基準得到了亞馬遜、ARM、百度、戴爾科技、Facebook、谷歌、哈佛大學、英特爾、聯想、微軟、斯坦福大學和多倫多大學等機構的廣泛支持。

更多的合作伙伴與結果提交數量

NVIDIA AI 平臺再次吸引了來自最廣泛合作伙伴生態系統的最多 MLPerf 提交。

Azure在12月份的MLPerf訓練測試中表現出色,在本輪AI推理測試中也取得了優異的成績,這兩場測試都使用了NVIDIA A100 Tensor Core GPU。Azure的ND96amsr_A100_v4實例在幾乎所有推理測試中都與我們提交的性能最高的8個GPU相媲美,展現了公共云隨時可以提供的能力。

系統制造商華碩和新華三在本輪測試中首次使用NVIDIA AI平臺提交MLPerf結果。他們加入了戴爾科技、富士通、技嘉、浪潮、聯想、寧暢和美超微等已經提交了二十多個NVIDIA認證系統結果的系統制造商的行列。

MLPerf的重要性

我們的合作伙伴深知MLPerf是一個客戶用來評估AI平臺和供應商的寶貴工具,因此紛紛參與這項測試。

MLPerf的各項測試涵蓋了當下最流行的AI工作負載和場景,用戶可以依據該基準了解AI平臺在各類工作中的預期性能。

憑借軟件大放異彩

我們在測試中使用的所有軟件都可以從MLPerf軟件庫中獲得。

我們的推理結果來自兩個關鍵組件——用于優化AI模型的NVIDIA TensorRT和用于高效部署模型的NVIDIA Triton推理服務器。您可以在我們的GPU優化軟件目錄NGC上免費獲得它們。

全球各地的企業機構正在采用Triton,包括Amazon和微軟等云服務提供商。

我們不斷將優化成果加入到NGC上的容器中,讓每一位用戶都能使用具有領先性能的AI進行生產。